Rails初心者の私が遭遇したエラーを列記していきます。

Railsは簡単にプログラムが作れて大変素晴らしいのですが、作者も言っているように「設定よりも規約」ですので色々な規約が存在します。裏を返せば少しでも規約に沿わなければ直ぐにエラーになります。たった一つの記号を忘れても直ぐにエラーになり、また、その際Railsはエラーが何処で起こったか表示をしてくれるのですが、よく、本当にエラーが起こった場所とは違う所を表示したりします。なので、初心者の私が遭遇したエラーを列記することにより、少しでも参考になればと思って、このカテゴリーを作りました。

カレンダー

2025年 5月

日 月 火 水 木 金 土 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 イベント開催日

-

最近の投稿

カテゴリー

- AlmaLinuxに挑戦

- Baclua(バックアップ)に挑戦

- CentOS 6

- CentOS7に挑戦

- dovecotの設定

- DRBDに挑戦(almalinux9)

- DRBDに挑戦(CentOS7)

- Linux運用時のメモ

- Rails 初心者の犯したエラー

- Ruby on RailsにEclipseを入れる

- Ruby on railsに挑戦(almalinux9)

- Window運用時のメモ

- WordPress関連メモ

- その他

- ヒマラヤ遠征報告書(1972年)

- メールサーバーに挑戦

- 危険メールや手紙、IP

- 太陽電池を使った無停電電源(サーバー用)奮闘記

- 未分類

- 省エネサーバー製作(CentOS 6)

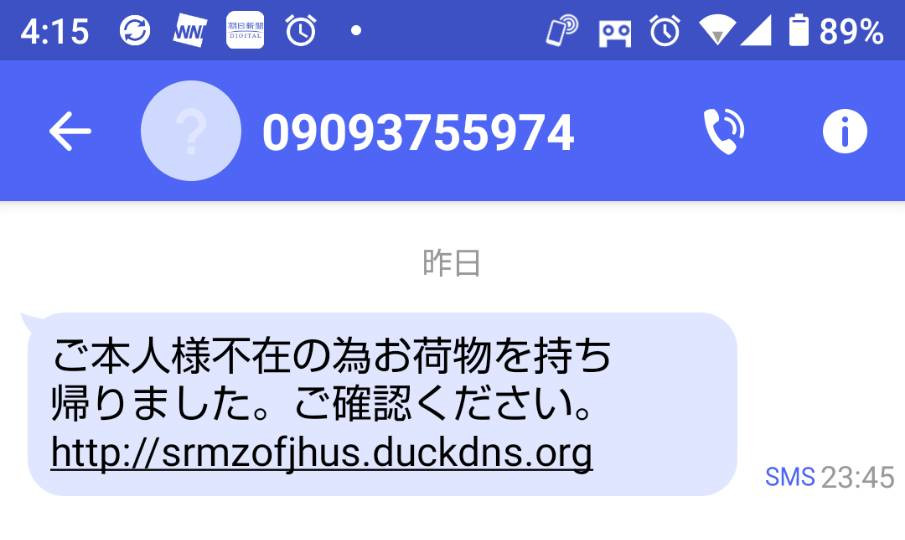

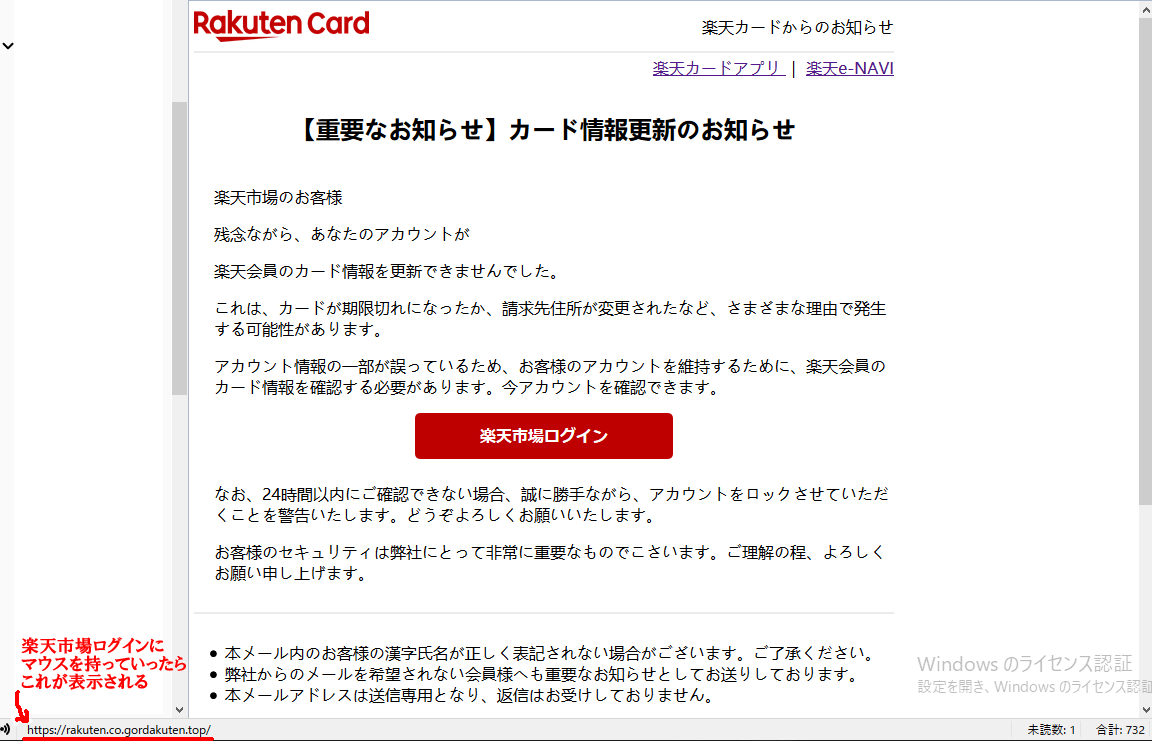

この所、一週間に一個ぐらいの割合で危険なメールが来ている!私が使っているメールサーバーはかなりセキュリティーを強くかけていて、正常なメールも弾かれるくらいの設定です。それでも来る。何回も言っているが、リンクは必ずマウスをそこにもって行き、左下などに表示される実際のリンク先を確かめる事。上の画像で左下の赤いアンダーラインのところが実際に飛ぶ場所であるが、

この所、一週間に一個ぐらいの割合で危険なメールが来ている!私が使っているメールサーバーはかなりセキュリティーを強くかけていて、正常なメールも弾かれるくらいの設定です。それでも来る。何回も言っているが、リンクは必ずマウスをそこにもって行き、左下などに表示される実際のリンク先を確かめる事。上の画像で左下の赤いアンダーラインのところが実際に飛ぶ場所であるが、

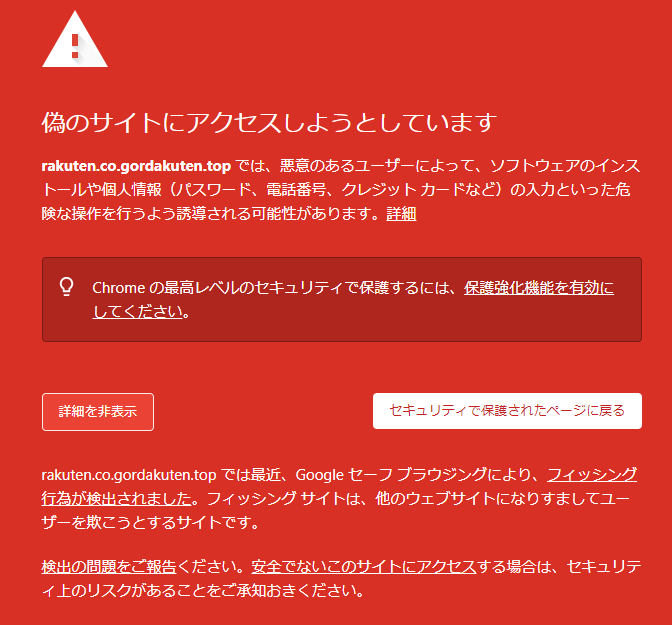

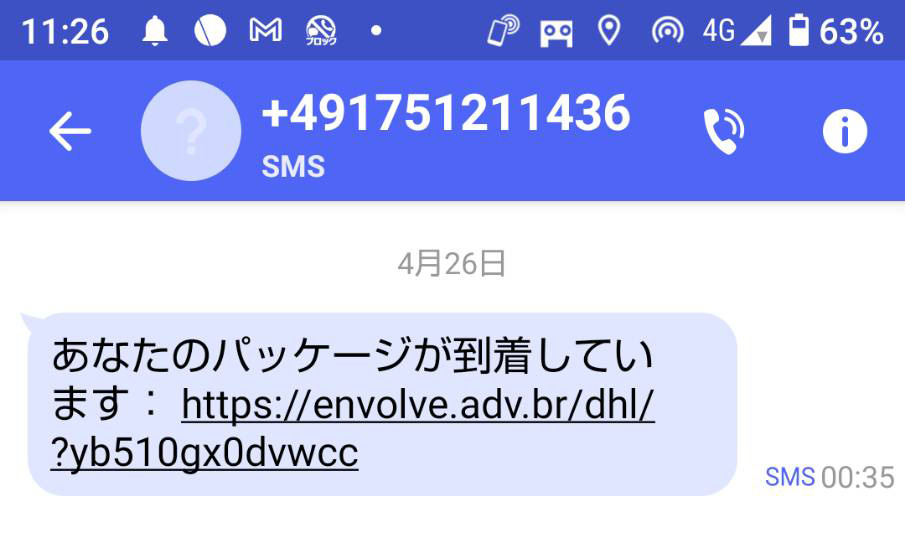

何度もここで警告しているが、こんな危険なメールが後を絶たない。

何度もここで警告しているが、こんな危険なメールが後を絶たない。